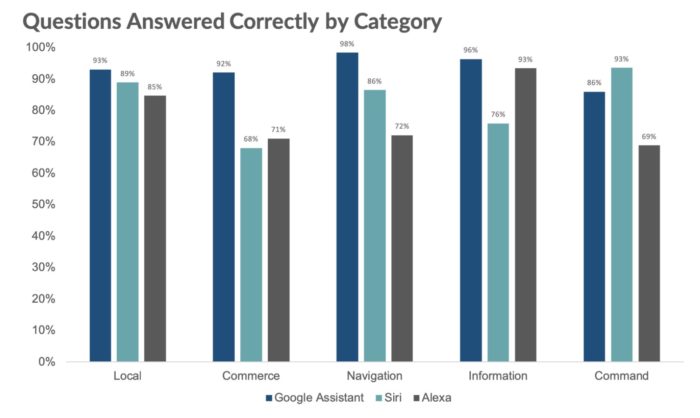

O levantamento foi feito a partir de 800 questões feitas para as três ferramentas. Pelo segundo ano, o Google Assistente entendeu 100% das perguntas. Ele ainda melhorou sua taxa de respostas adequadas, passando de 85,5%, em 2018, para 92,9%. A Siri, por sua vez, entendeu 99,8% do que foi dito. Em 2018, o índice foi de 99%. A assistente da Apple também passou a dar mais respostas adequadas, subindo de 78,5% para 83,1%. Já a Alexa entendeu 99,9% das perguntas – em 2018, a taxa era de 98% – e respondeu adequadamente a 79,8% delas – a taxa era de 61,4%. O teste do Google Assistente foi feito em um Pixel XL, enquanto o da Siri foi realizado em um iPhone com iOS 12.4 e o da Alexa foi feito por meio de seu aplicativo para iOS. O comparativo envolveu cinco categorias de perguntas: local, comércio, navegação, informação e comando.

A ferramenta do Google liderou em quatro categorias e teve a maior margem em comércio, que envolve mensagens como “peça-me mais papel-toalha”. Ela respondeu corretamente a 92% das perguntas, enquanto a Alexa teve taxa de acerto de 71% e a Siri, de 68%. “O senso comum sugere que a Alexa seria mais adequada para questões de comércio”, afirma a Loup Ventures. “No entanto, o Google Assistente responde corretamente a mais perguntas sobre informações de produtos e serviços e onde comprar determinados itens”. O único segmento em que o Google Assistente não lidera é o de comando, que inclui mensagens como “lembre-me de ligar ao Jerome às 14h hoje”. A Siri se saiu melhor ao responder a 93% das perguntas corretamente. A taxa de acerto do Google Assistente foi de 86% e a da Alexa, de 69%. “Tanto Siri quanto Google Assistente, que são integrados ao sistema operacional do telefone, superaram em muito a Alexa na seção comando”, diz a Loup Ventures. “A Alexa permanece em um aplicativo de terceiros que apesar de poder enviar mensagens de voz e chamar outros dispositivos Alexa, não pode enviar mensagens de texto, e-mails nem iniciar uma ligação”. Para este ano, o comparativo não avaliou a Cortana por conta da decisão da Microsoft de mudar seu “posicionamento estratégico”. Em 2018, quando foi avaliada, a assistente entendeu 99,4% das perguntas, mas respondeu corretamente a somente 52,4% delas. Com informações: VentureBeat.